Arbeitsgruppe definiert Regeln für Umgang mit KI in der Wissenschaft

Die von künstlicher Intelligenz erzeugten Texte, Videos und Bilder lassen sich kaum mehr von denen von Menschen unterscheiden. Eine internationale Arbeitsgruppe hat daher Regeln für den Umgang mit KI in der Wissenschaft definiert.

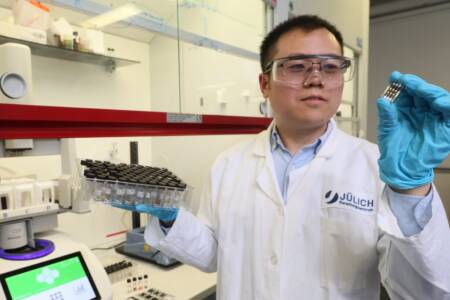

Foto: panthermedia.net/ Kittipong Jirasukhanont

Inhaltsverzeichnis

Vertrauen in die Forschung entsteht dadurch, dass Ergebnisse unabhängig von ihrem Entstehungsort gültig sind. Es ist wichtig, dass die zugrunde liegenden Daten veröffentlicht werden und Forschende Verantwortung für ihre Publikationen übernehmen. Was passiert jedoch, wenn KI mitforscht? Fachleute nutzen bereits KI-Werkzeuge, um neue Moleküle zu entwerfen, komplexe Daten auszuwerten und Forschungsfragen zu generieren. KI verändert die Forschung massiv. Daher diskutiert die Fachwelt, wie Ergebnisse trotzdem vertrauenswürdig bleiben können.

Künstliche Intelligenz in der Wissenschaft

Die Entwicklung von KI hat in den letzten Jahren beeindruckende Fortschritte gemacht. In naher Zukunft wird KI eine entscheidende Rolle in allen Bereichen der Wissenschaft spielen. Ihr Einfluss reicht von der Medizin über die Umweltschutzforschung bis zur Lösung komplexer mathematischer Probleme. Auf dem Weg in diese KI-gesteuerte Zukunft stellen sich wichtige Fragen bezüglich ihrer Kontrolle und Verantwortung. Kann die rasante Entwicklung der KI noch vom Menschen kontrolliert und gelenkt werden? Technologische Fortschritte könnten außer Kontrolle geraten, wenn sie nicht ausreichend reguliert werden. Die Verantwortung für die Entwicklung und Nutzung von KI liegt sowohl bei den Entwickelnden als auch bei der Gesellschaft als Ganzes. Eine klare ethische und rechtliche Rahmenarbeit ist wichtig, um sicherzustellen, dass KI im Einklang mit unseren Werten und Zielen steht.

Forderungen im Fachmagazin PNAS veröffentlicht

Eine interdisziplinäre Arbeitsgruppe hat fünf Prinzipien formuliert, um die menschliche Verantwortung in der Forschung zu sichern. Diese Forderungen wurden in der neuesten Ausgabe der Fachzeitschrift Proceedings of the National Academy of Sciences (PNAS) veröffentlicht. Auch Urs Gasser, Professor für Public Policy, Governance and Innovative Technology an der Technischen Universität München, hat daran mitgewirkt.

Die fünf Prinzipien im Überblick

- Wissenschaftler sollen offenlegen, welche Tools und Algorithmen sie benutzt haben und die Beiträge von Maschine und Mensch klar kennzeichnen.

- Forschende tragen weiterhin die Verantwortung für die Genauigkeit der Daten und die daraus gezogenen Schlussfolgerungen, auch wenn KI-Analysetools verwendet wurden.

- KI-generierte Daten müssen kenntlich gemacht werden, um Verwechslungen mit realen Daten zu vermeiden.

- Fachleute müssen sicherstellen, dass ihre Ergebnisse wissenschaftlich fundiert sind und keinen Schaden anrichten. Das Risiko einer Voreingenommenheit der KI durch Trainingsdaten muss minimiert werden.

- Forschende zusammen mit Politik, Zivilgesellschaft und Unternehmen sollen die Auswirkungen von KI überwachen und Methoden sowie Regeln anpassen.

Strategierat zur Unterstützung der Wissenschaft geplant

„Bisherige KI-Prinzipien betreffen vor allem die Entwicklung von KI. Die nun erarbeiteten Grundsätze fokussieren dagegen auf die Nutzung in der Wissenschaft und kommen zur richtigen Zeit. Sie haben Signalwirkung für Forschende über Disziplinen und Sektoren hinweg“, erläutert Gasser.

Auch interessant: Karriere-Podast: Macht künstliche Intelligenz die Ingenieurjobs überflüssig?

Ein neuer Strategierat bei der Nationalen Akademie der Naturwissenschaften, Ingenieurwissenschaften und Medizin der USA soll der Wissenschaft beratend zur Seite stehen. „Ich wünsche mir, dass Wissenschaftsakademien in anderen Ländern – namentlich auch hier in Europa – den Ball aufnehmen und die Diskussion um den verantwortungsvollen Umgang mit KI in der Forschung weiter verstärken“, so Gasser.