Cloud-Services erobern den Mittelstand

Cloud-Dienste sind Voraussetzung für Anwendungen von Industrie 4.0 und maschinelles Lernen. Wie die auch für kleine Unternehmen nutzbar werden, erklärt Constantin Gonzalez von Amazon Web Services.

Foto: F4D Studio

VDI nachrichten: Cloud ist für viele Menschen ein wolkiger Begriff. Worüber sprechen Sie, wenn es um Cloud-Dienste geht?

Gonzalez: In vielen Köpfen ist die Cloud eine virtuelle Maschine, ein virtueller Server und Speicher. Tatsächlich hat sich die Cloud in den vergangenen Jahren sehr stark weiterentwickelt. Wir haben bei Amazon Web Services im Moment über 200 verschiedene Dienste. Wir wollen es den Kunden damit leichter machen und den Schmerz aus der IT rausnehmen.

Welchen Schmerz meinen Sie?

Es geht immer erst einmal darum die Hardware zu beschaffen, sie dann aufzustellen, zu installieren und zum Laufen zu bringen. Dann kann man mit der Softwareebene weitermachen, wo man sich dann mit Application-Servern, Datenbanken und anderen Dingen beschäftigen muss. Erst danach kommt man zu dem, was wirklich für das Geschäft wichtig ist.

Die Vorteile von Cloud-Lösungen

Könnten Sie einem Mittelständler, der bisher noch nichts mit Amazon Web Services zu tun hatte, die Vorteile Ihrer Lösungen in zwei Sätzen beschreiben?

Ich versuche es: Mit den Cloud-Services von AWS kann ich mich in kürzester Zeit auf mein Kerngeschäft konzentrieren, ohne mir den klassischen Aufwand der IT antun zu müssen. Und ich kann damit schnell neue Produkte und Services für mein Geschäft aufbauen, experimentieren und schneller herausfinden, was meine Kunden wirklich wollen.

Um eine Größenordnung zu bekommen: Was ist Ihr größtes industrielles Cloud-Projekt?

Wir haben in Deutschland eine große Palette an Unternehmen, die unser Angebot nutzen. Das sind über 80 % der im DAX 30 notierten, aber auch viele mittelständische Unternehmen und Start-ups. Bei den großen Projekten sprechen wir mit Konzernen wie Siemens und BMW.

Mit Siemens haben wir viele Projekte, bei denen auch künstliche Intelligenz zum Einsatz kommt. Zu nennen ist da die IoT-Plattform Mindsphere, wo es viele Beispiele dafür gibt, wie maschinelles Lernen produktiv in der Industrie eingesetzt werden kann. Das Grundprinzip ist es, beim maschinellen Lernen möglichst viele Daten zu sammeln und daraus Mehrwerte zu schöpfen.

Beispiele

Können Sie dazu bitte ein konkretes Beispiel nennen?

Zusammen mit einem Ventilhersteller hat Siemens beispielsweise Sensordaten gesammelt und in der Cloud zu einem Machine-Learning-Modell verarbeitet. Das Modell wird in der Fabrik nah am Ventil in einer Steuerung eingesetzt, wo damit drohende Ausfälle frühzeitig erkannt werden können. Das ist die Machine-Learning-Kette, die wir in der Industrie immer wieder finden.

Beim BMW Cloud Data Hub ist es ähnlich, nur werden da Fahrzeugdaten gesammelt und den Partnern zur Verfügung stellt.

Wie sehen Ihre kleinsten Cloud-Anwendungen aus?

Das lässt sich an unserem Produkt Amazon Monitron gut erklären. Damit vereinfachen wir die eben beschriebene Kette, wo meist noch die Expertise unserer Partner wie Siemens gefragt ist. Denn für kleine Unternehmen lohnt sich der Aufwand oft nicht oder eine alte Maschine liefert gar keine Daten dazu. Das lösen wir mit dem Monitron Starter Kit, das aus einem Hub besteht – also dem Gerät, das man mit dem WLAN verbindet – und aus Sensoren, die an der Maschine angebracht werden. Dazu gehört eine App, die mir die Daten anzeigt. Das machen wir z. B. zusammen mit einem Automobilzulieferer, der damit sicherstellen will, dass seine alten Druckluftkompressoren laufen, weil das für die Fabrik wichtig ist.

Mit Amazon Monitron kann ich jetzt also meine Sensoren da drankleben. Die verbinden sich per Bluetooth Low Energy mit dem Steuergerät. Sie liefern Sensordaten wie Vibration und Temperatur in die Cloud. Der Monitron-Service sammelt dann Daten vollautomatisch und errechnet Modelle, die für diese Maschine angepasst sind. Am Ende bekommt der Mitarbeiter die Kurven über die Zeit auf seinem Handy angezeigt und erhält eine Warnung, wenn sich der Kompressor ungewohnt verhält.

Von welchen Investitionen sprechen wir da?

Das Monitron-Starterkit kostet mit allem, was ich dazu brauche, 615 €. Dazu kommt noch eine monatliche Gebühr von weniger als 4 € pro Sensor. Mit den im Starterkit enthaltenen Sensoren kann ich fünf Maschinen anschließen. Damit verhindere ich aber, dass eine Maschine meine ganze Produktion lahmlegt, weil sie unerwartet ausfällt. Gleichzeitig kann ich Kosten vermeiden, indem ich die Wartungszyklen bei kritischen Maschinen anpassen kann und nicht vorsorglich Komponenten austausche.

Vom Kunden her denken

Es gibt viele Anbieter von Cloud-Diensten. Wie differenziert sich AWS von den Wettbewerbern?

Wir denken vom Kunden her – in unserem Jargon sprechen wir von „working backwards“ – und starten mit dem Problem, das den Anwender davon abhält, produktiv zu sein. Dann kommen wir zu einer Lösung, die zu dem konkreten Problem passt. Bei anderen Firmen ist man oft technikverliebt. Da wird ein cooles Produkt entwickelt und dann geschaut, wie es sich verkaufen lässt. Das produktzentrische Denken löst aber noch keine Probleme. Deswegen machen wir das umgekehrt.

Können Sie sagen, wie viel Zeit ein Unternehmen mit Ihren Lösungen gegenüber klassischen Entwicklungsprozessen spart?

Wir sehen typischerweise, dass unsere Kunden in drei Wochen einen Prototyp haben, für den sie vorher drei Monate oder länger gebraucht hätten. Das hängt von der jeweiligen Philosophie ab.

Manche Unternehmen neigen dazu, in ihrem Elfenbeinturm Jahre zu verbringen, bevor ein Produkt herauskommt, was gleich perfekt sein muss.

Wir erleben es immer häufiger, dass Kunden den Mehrwert vom Experimentieren sehen und einfach mal was ausprobieren. Da habe ich in einer Woche einen ersten Prototyp und drei Wochen später ein Ergebnis, das ich auf einer Messe präsentieren kann. Durch das Feedback kann ich das dann in einem Monat zu einem neuen Service oder einem neuen Produkt weiterentwickeln.

Damit können unsere Kunden ihre Produktentwicklungszyklen dramatisch beschleunigen – auch weil sie sich nicht mehr um die nötige Infrastruktur kümmern müssen.

Anforderungen der Industrie

Welche speziellen Anforderungen sehen Sie in der Industrie?

In der Industrie sehe ich häufig, dass Fertigungen nicht unbedingt in Ballungsräumen aufgebaut werden. Wir haben Großkunden, die überall in der Welt Fertigungen haben, weil sie nah bei den Kunden sein wollen. Das ist insbesondere in der Automobilindustrie der Fall. Gerade für deutsche Unternehmen ist es eine große Herausforderung, für diese Produktionsstätten die richtige IT zur Verfügung zu stellen. Da müssten sie überall ein Rechenzentrum aufbauen.

Machen Sie das mal in Brasilien. Da müssen Sie sich überall mit den lokalen Gesetzmäßigkeiten auskennen. Dagegen ist es viel einfacher, die Funktionalitäten in der Cloud bereitzustellen. Das hat AWS alles schon geregelt.

Dazu betreiben wir im Großraum São Paulo eine Region in der Cloud, wo ich dann aus ganz Brasilien virtuelle Rechenzentren starten kann. Damit kann ich die IT, die ich für die Fabrik brauche, dort einfach aufbauen.

Das ist gerade für deutsche mittelständische Unternehmen ein großer Vorteil, weil sie damit sehr schnell sein können. Das ist das Schöne. Denn in Deutschland haben wir viele Betriebe – auch Familienunternehmen –, die weltweit Marktführer sind. Diese Firmen tun sich mit der Cloud wesentlich leichter, global zu expandieren.

Aber habe ich abseits der Ballungsräume überhaupt die nötige Kommunikationsinfrastruktur? Wie sieht das genau aus?

Das bedeutet beispielsweise, eine bessere Integration etwa von Steuergeräten mit Cloud-Services zu machen oder lokale Logik vorzuhalten. Dafür haben wir die Software AWS IoT Greengrass. Die anfangs erwähnte Ventilüberwachung läuft dann in einem sogenannten Greengrass-Container vor Ort auf dem Steuergerät. Wenn das Netz funktioniert, können damit Daten ausgetauscht werden, wenn nicht, dann trifft das System lokale Entscheidungen und kann damit weiterarbeiten – unabhängig von der Cloud. Durch diese Aufteilung können Kunden beide Vorteile nutzen.

Ähnlich kann ich das mit Softwarelösungen wie Manufacturing Execution Systemen (MES) machen. Da habe ich nur die kritischen Teile in der Produktionsanlage und brauche lediglich den Platz, die Kühlung und das Netzwerk. Die Entwicklungsumgebung, Administration und Organisation bleiben komplett in der Cloud.

Wir sprechen dabei aber von Kabeln für die Cloud-Anbindung, oder geht das dann über Mobilfunktechnik wie 5G?

Es gibt beides. Viele Kunden von uns arbeiten mit 5G und beginnen darüber Industrieanwendungen zu realisieren. Wir arbeiten dazu auch mit den großen Telekommunikationsunternehmen zusammen. Der Service von uns dazu heißt AWS Wavelength, wie die Wellenlänge. Da geht es darum, Cloud-Server direkt im Funkturm zu haben. Wenn ein Kunde nicht das komplette Rack im Rechenzentrum benötigt, sondern eine 5G-Anbindung beim Telekommunikationsanbieter hat, dann kann die IT in den 5G-Turm verlagert werden. Auch da muss ich sie nicht mehr selbst betreiben, bleibe aber bei niedriger Latenz mit dem Netz verbunden.

Die IT-Sicherheit hat oberste Priorität

Die technischen Möglichkeiten sind das eine, aber wie überzeugen Sie gerade Mittelständler davon, ihre Daten auszulagern?

Bevor wir anfangen über Produkte zu reden, denken wir über Sicherheit nach. Das hat für uns alleroberste Priorität. Das muss geklärt sein, bevor wir den ersten Schritt machen. Ich habe zu viele Projekte erlebt, wo man erst zum Schluss über Sicherheit nachgedacht hat. Da bekommt man eine Lösung, vor die dann irgendeine Firewall installiert wird. Das reicht aber nicht. Denn wenn man die überwunden hat, ist man in einer vollkommen unsicheren Umgebung.

Und wie sorgen Sie für die Sicherheit der Daten?

Durch die komplette Automatisierung unserer virtuellen Hardware können wir es so einrichten, dass die Hardware vollständig von unseren Kunden kontrolliert wird. Das zieht sich durch alle unsere Services. Die Geschäftsgrundlage ist ja, dass wir unseren Kunden unsere Infrastruktur so zur Verfügung stellen, als wäre es ihre eigene.

Unsere Kunden haben 100 %ige Kontrolle darüber, was sie mit ihrer virtuellen Maschine machen, also auch wie und wo sie ihre Daten speichern – in welchem Land. Wir empfehlen ihnen, ihre Daten jederzeit zu verschlüsseln, und bieten ihnen auch Werkzeuge, die ihnen das leicht machen.

Wir sind kein Outsourcer, sondern das Ganze ist eher vergleichbar mit ferngesteuerter Hardware. Wir geben den Kunden den vollen Zugang zu unserer Hardware und sie können damit machen, was sie wollen.

Wie sieht es denn dann mit der Verantwortung aus, falls doch etwas schiefgeht?

Wir haben das Modell der geteilten Verantwortung, das heißt, wir als AWS sind verantwortlich für die physische Sicherheit. Das umfasst beispielsweise die Gebäude, die Rechenzentren, die Netzwerksicherheit, die Hardware. Dafür stehen wir in der Verantwortung, bis dann die Übergabe an unsere Kunden stattfindet – nämlich der virtuelle Server, der Speicher und der Service.

Ab dieser Ebene haben die Kunden die volle Kontrolle darüber und sind dann auch verantwortlich dafür, was sie damit machen. Dazu gehören auch die Installation eines Virenscanners, regelmäßige Patches und Updates, wie sie es in ihrem eigenen Rechenzentrum auch tun würden.

Über das Modell der geteilten Verantwortung können dann Kunden ihre volle Autonomie in der Cloud ausleben und etwa über Verschlüsselung dafür sorgen, dass ihre Daten jederzeit unzugänglich für alle anderen aufbewahrt werden. Damit fühlen sich die meisten unserer Kunden sehr wohl – nicht nur Mittelständler, sondern auch Großkunden wie BMW oder Siemens.

Domain-Know-how an jedem Ort

Anderes Thema: Beim maschinellen Lernen nutzen manche Anwender externe Lösungen und andere setzen auf das Domain-Know-how ihres eigenen Unternehmens. Wie gehen Sie damit um?

Unsere Kunden aus der Fertigung haben sehr gutes Domain-Know-how. Das Problem ist, dass dieses Know-how immer auf wenige Experten begrenzt ist. Früher mussten diese Leute immer irgendwohin geflogen werden, wenn irgendwo auf der Welt irgendetwas nicht funktionierte. Mithilfe der Cloud kann quasi Telemedizin für die Industrie bereitgestellt werden.

Per Videostreaming, Videokonferenzen, Sensordaten kann das Domain-Know-how vor Ort gebracht werden, ohne selbst hinfliegen zu müssen. Die Arbeit des Domain-Experten kann dadurch erleichtert und damit auch wertvolle Zeit eingespart werden.

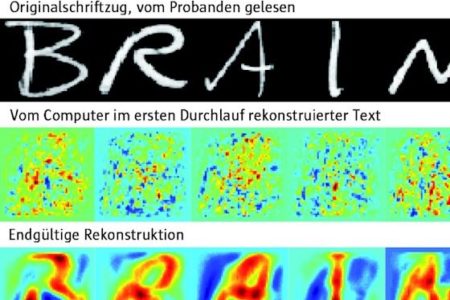

Ein Machine-Learning-Algorithmus ist nie perfekt, sondern funktioniert erst mal statistisch. Wenn also 100 000 Teile auf dem Band liegen, dann kann der Experte nicht auf jedes einzelne Teil schauen, das würde ewig dauern. Aber mit Machine Learning kann eine Vorauswahl getroffen werden, wenn der Algorithmus feststellt, dass mit 99 500 Teilen alles okay war, aber die letzten 500 Teile vielleicht fraglich sind. Da muss sich der Domainexperte dann nur noch die anschauen, wo die Entscheidung schwierig ist, und kann gezielt und produktiv sein Wissen einsetzen.

Es geht also um die Entlastung von Experten?

Ja. Machine Learning agiert wie ein Hebel für die Experten. Es ist wie ein Fahrrad, um schneller von A nach B zu kommen, obwohl ich selbst auch tätig werden muss. Das finde ich eine ganz wichtige Botschaft: Das ist ein guter Weg, um die doch überall sehr begrenzte Expertenkapazität mit Machine Learning zu skalieren und damit noch breiter zugänglich zu machen.

Oft ist es erforderlich, dass bestimmte Bereiche immer wieder auf Daten anderer Bereiche zugreifen können. Wie ist das bei AWS geregelt?

Kunden können granular einstellen, wer wann unter welchen Bedingungen auf welche Daten zugreifen darf. Ein Beispiel dafür ist der BMW Cloud Data Hub. Wenn sich jemand bei BMW anmeldet, bekommt er vom Konzern eine BMW-ID und damit Zugang zu bestimmten Daten, die BMW für bestimmte Kundengruppen wie BMW-Händler oder Privatkunden erlaubt. Es können also mächtige Zugangskontrollen und Richtlinien eingestellt werden.

Der Mittelstand und die Cloud

Sie nannten gerade wieder einen Konzern, wie viele Mittelständler entscheiden sich denn für AWS?

Wir haben Amazon Web Services 2006 gegründet, und starteten damals mit einem Speicherservice, genannt Simple Storage Service, S3. Und wir waren von Anfang an sehr überrascht und begeistert, wie viele unterschiedliche Kunden diese Plattform genutzt haben. Wir hätten uns nie träumen lassen, dass Unternehmen wie AirBNB, Netflix oder Soundcloud ihr Geschäft nahezu vollständig auf die Cloud aufbauen würden. Aber diese haben erkannt, dass sie ihre Dienste ihren Kunden viel einfacher zur Verfügung stellen können, wenn die Daten in der Cloud liegen.

Und wie sieht es mit Industrieanwendungen aus?

Einer unserer ganz frühen Kunden war Kärcher. Das Unternehmen hat bereits vor vielen Jahren die Globalisierungsmöglichkeit genutzt. Kärcher stellt Kehr- und Reinigungsmaschinen her, die in der Cloud koordiniert werden können. Da geht es um Fragen wie: Wann muss welche Maschine an welchem Platz in einem 80-stöckigen Hochhaus sein? Wann können Räume und Etagen am effektivsten gereinigt werden, ohne den laufenden Betrieb zu stören? Für die Planung der Reinigungsmaschinen hat Kärcher schon vor vielen Jahren in der Cloud ein Planungs- und Koordinationstool entwickelt und weltweit ausgerollt.

Machine Learning einfach gemacht

Gibt es weitere Beispiele, die auch Aspekte des Machine Learning beinhalten?

Natürlich. Ein sehr einfaches, aber witziges Beispiel ist Dafgards, ein Hersteller u. a. von Tiefkühlpizzen. Dieser verwendet zur Qualitätssicherung Amazon Lookout for Vision. Das ist ein Machine-Learning-Service für die bildgestützte Qualitätserkennung. Eine Kamera über dem Fließband nimmt pro Pizza ein Bild auf und kann anhand von Beispielbildern trainiert werden zu erkennen, ob die Pizza richtig mit den ausreichenden Mengen belegt ist und ob die Verteilung der einzelnen Bestandteile stimmt.

Dieselbe Technik kann man in vielen Bereichen einsetzen, z. B. bei der Schraubenherstellung. Einen Menschen jede produzierte Schraube kontrollieren zu lassen, würde Ewigkeiten dauern.

Das ist ja eine wirklich einfache Lösung, doch es gibt durchaus anspruchsvollere Aufgaben.

Absolut richtig, dafür haben wir bei AWS ein ganzes Portfolio von Lösungen und Services. Das ist bei uns in drei Schichten gegliedert. Neben Software und Framework bildet die Infrastruktur die Basis, das heißt, Hunderte unterschiedlich aufgebaute Servertypen, bei denen Kunden den für sie passenden Typ aussuchen können. Auch für das Machine Learning besonders optimierte Typen, die über eingebaute Graphics Processing Units, sogenannte GPUs, verfügen.

Die man eigentlich eher aus der Computerspielbranche kennt …

Dazu ein kleiner Exkurs: Machine Learning ist mathematisch betrachtet eine Vielzahl von Matrixmultiplikationen. Das bedeutet, wenn Kunden ein Machine-Learning-Modell antrainieren, dann muss der Computer unglaublich viele Vektoralgorithmen und Matrixmultiplikationen durchführen. Zufällig ist es so, dass die 3-D-Computergrafik, die wir von Computerspielen kennen, aus einem völlig anderen Ansatz genau das Gleiche machen muss. Daher haben sich die Grafikkarten und die darauf spezialisierten GPUs als Arbeitstiere für Machine Learning durchgesetzt. Wir liefern Instanzen mit den modernsten GPUs von Nvidia, die unsere Kunden nutzen können, um Machine Learning zu trainieren.

Nun sind GPUs unglaublich leistungsstark und in der Praxis, wie im Beispiel mit der Tiefkühlpizza, wird nur ein Bruchteil davon benötigt. Es wird also nur ein kleiner Teil der GPU benötigt. Würde die Qualitätssicherung selbst betrieben werden, wäre so eine teure GPU Verschwendung und überdimensioniert – etwa so, als würde eine Pizza mit einem 38-Tonner ausgeliefert.

Daher haben wir spezialisierte Chips entwickelt, die genau für diesen Inferenzfall optimiert sind und damit zu niedrigeren Kosten bei höherer Performance Machine Learning in der Praxis umsetzen können. Doch das ist eher was für Spezialisten, dazu sollte man genau wissen, was man tut und was man braucht. Aber wir haben sehr viele Kunden, die solche Experten zur Verfügung haben, die genau diese Ebene suchen und verlangen.

Trotzdem fällt es vielen Mittelständlern schwer, maschinelles Lernen (ML) bei sich einzusetzen – auch weil dafür die Fachleute fehlen. Was machen Sie mit denen?

Für solche Kunden haben wir eine ganze Familie von Services entwickelt, die bei uns Amazon Sagemaker heißt. Das ist eine Art Machine-Learning-Werkbank für Ingenieure, Entwickler und Data-Scientists mit den kompletten Werkzeugen, um mit den Daten rumzuspielen, Algorithmen auszuprobieren sowie zu trainieren und Daten aufzubereiten. Wenn man den richtigen Algorithmus gefunden hat, kann weiter getestet und optimiert werden. Daraus entsteht dann ein fertiges ML-Modell, das auf den Geräten oder in der Cloud ausgerollt werden kann. Diesen gesamten Zyklus unterstützt Sagemaker.

Vorgefertigte KI-Services

Das setzt aber immer noch Experten voraus, die wissen, welche Algorithmen sie benötigen.

Dafür gibt es fertige KI-Services. Diese sind so benutzerfreundlich aufgebaut, dass die Kunden keine Erfahrung in Machine Learning mitbringen müssen. Experten oder Data-Scientists sind hier nicht nötig. Warum? Der Kunde kann die KI-Services nehmen und ganz einfach wie eine Software-Bibliothek in der Cloud einsetzen.

Haben sie Beispiele dafür?

Ja, z. B. Amazon Rekognition. Man kann ein Foto in den Service hochladen und Rekognition sagt dem Kunden dann, was darauf ist. Ein klassischer Bilderkennungsservice. Ein ganz einfaches Beispiel dafür ist ein Firmenlogo, mit dem viele Kunden ihre Produkte versehen. Da können in Rekognition dann ein paar Hundert Firmenlogos aus verschiedenen Perspektiven hochgeladen werden.

Kunden wollen dann wissen, wer auf welchen Marktplätzen Produkte mit ihrem Logo hochgeladen hat, um so etwa vollautomatisch Plagiate zu erkennen. Es gibt weitere Services für die Sprachverarbeitung oder auch für die Textverarbeitung. So werden Trendbarometer erstellt.

Gibt es auch Services für die Logistik?

Absolut. Die Kollegen vom Amazon Webshop optimieren ihre Logistik mit den AWS-Services. Kürzlich gab es wieder mal den Amazon Prime Day, der sehr viel Traffic generiert und regelmäßig eine enorme logistische Herausforderung darstellt. Trotzdem sind die Produkte am nächsten Tag da. Dazu gehört, dass Machine Learning an jedem Segment der logistischen Kette einsetzt. Das heißt also: Wie viel muss ich von jedem Produkt einkaufen und bei welchem Händler? Wie viel von welchem Produkt muss ich in welchem Lager vorhalten? Welches Produkt wird in welchem Postleitzahlenbereich besonders häufig bestellt? Wie muss ich meine Lieferkette schon im Vorfeld darauf optimieren, dass ich möglichst schnell ausliefern kann? Wenn die Bestellung kommt, welchen Lieferdienst wähle ich, um besonders schnell ausliefern zu können? An jeder dieser Stellen kommen Forecasting-Algorithmen zum Einsatz, die diese Voraussagen treffen können. Das Know-how, das wir in den letzten 15 Jahren in diesem Bereich gesammelt haben, gibt es runterdestilliert in einem ganz einfachen Service, der bei uns Amazon Forecast heißt – für Kunden in der Logistik.

Anderes Beispiel: Ein Freund hat sich selbstständig gemacht und betreut ein Warenlager für die Getränkeindustrie. Er hat den Amazon-Forecast-Service genommen und dort Excel-Daten importiert – also historische Bestelldaten, wie: Was habe ich wann wohin geliefert und wie lange hat es gedauert? Das Ganze kann dann mit Daten korreliert werden, die für die Lieferung wichtig sind, etwa Kalenderdaten mit den Feiertagen oder Wetterdaten. Forecast kann dann für die Zukunft voraussagen, dass eine bestimmte Menge an einem bestimmten Tag über Carrier A drei Tage braucht, über Carrier B nur zwei Tage. In der Lieferplanungsoptimierung sehen viele Kunden Wettbewerbsvorteile.