Wettrennen der Superrechner

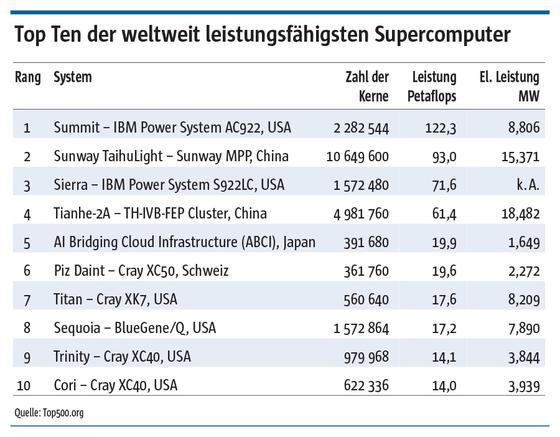

Die bisherigen Spitzenreiter aus China wurden in der Liste der schnellsten Computer durch zwei neue Rechner aus den USA auf die Plätze verwiesen.

Foto: M. Matzer

Neuer Spitzenreiter in der jüngsten Top500-Liste der weltweit schnellsten Computer ist das IBM-System „Summit“, das am Oak Ridge National Laboratory des US-Energieministeriums durchschnittlich 122,3 Petaflops Leistung (Billiarden Gleitkommaoperationen pro Sekunde) erbringt. Begnügt man sich mit halber Präzision bei den Berechnungen, so soll der Rechner sogar 2,9 Exaflops leisten können, also den Bereich von Trillionen Fließkomaoperationen pro Sekunde erreichen. Die schnellsten derzeit verfügbaren Grafikprozessoren (GPU) aus dem Hause Nvidia, Tesla V100, arbeiten hier mit Prozessoren des Typs Power9 von IBM zusammen.

Ganz ähnlich aufgebaut ist die neue Nummer drei der Liste, das IBM-System „Sierra“, das mit seinen 4320 Prozessoren eine Leistung von durchschnittlich 71,6 Petaflops erbringt. Damit steht der bisherige Spitzenreiter, der chinesische Superrechner Sunway TaihuLight, jetzt an zweiter Position, der bisher zweitplatzierte Tianhe-2A rutscht nun auf Platz vier (s. Tabelle). Nach einem größeren Upgrade mit neuen Koprozessoren erbringt er jetzt 61,4 Petaflops, vorher waren es 33,9 Petaflops.

Schnellrechner und Energiesparer: Auf dem Weg zu weiterer Steigerung der Rechenleistung im High-Performance-Computing (HPC) auf Exascale-Niveau ist der Stromverbrauch für die Kühlung der Rechner die größte Hürde. Doch die Entwicklung verläuft hier zumindest teilweise bereits in der richtigen Richtung. So liegt der Energieverbrauch von Superrechner Nummer fünf trotz seiner Leistung von 19,9 Petaflops (in der Spitze sogar 32,58 Petaflops) bei lediglich 1,65 MW. Der von Fujitsu gebaute Rechner namens „AI Bridging Cloud Infrastructure“ spart Strom u. a. durch den konsequenten Einsatz sparsamer GPUs. Auf der Liste der energieeffizientesten Superrechner, der Green500, belegt er Platz acht.

Mit 2,2 MW Stromverbrauch ist der schnellste europäische Superrechner die Nummer sechs auf der Top500-Liste und die Nummer zwölf auf der Green500-Liste. Der Piz Daint, der in Lugano für den Schweizer Wetterdienst rechnet, erbringt mit diesen 2,2 MW eine Leistung von 19,6 Petaflops (25,3 Petaflops Spitzenleistung). Und dabei hat er noch nicht einmal ein Upgrade mit den neuesten GPUs erhalten.

Gemessen wird die Rechenleistung der Supercomputer in der Top500-Liste mit dem sogenannten Linpack-Benchmark. „Sie messen nur die Leistung des Rechners beim Lösen eines großen Gleichungssystems“, gibt der Leiter des Höchstleistungsrechenzentrums Stuttgart (HLRS), Michael Resch, zu bedenken. „Aber zur Leistung eines Supercomputers gehört auch die Kommunikation, die von diesen Benchmarks weitgehend vernachlässigt wird.“ Der aktuell interessanteste Benchmark-Test heißt HPCG. Er ist laut Resch eine erhebliche Verbesserung gegenüber Linpack, weil er realistischer die Leistung der Systeme wiedergibt. Doch für den Vergleich habe Linpack auch Vorteile, da er helfe, „aktuelle Architekturen mit älteren zu vergleichen und zu sehen, in welche Richtung wir uns bewegen“.

HPC aus der Cloud: Auf der International Supercomputing Conference Ende Juni in Frankfurt am Main wurde auch wieder HPC als Dienstleistung aus der Cloud angeboten, so etwa von isländischen Rechenzentren, die kostengünstig betrieben werden, weil sie ihre Energie aus dem Erdinneren beziehen. Doch HLRS-Leiter Resch relativiert: „Alles, was viele kleine Probleme löst, ist in der Cloud sehr gut aufgehoben. Typische Beispiele sind die Parameterstudien, die man im Bereich der Klimasimulation macht, oder auch im Bereich der Crash-Simulation.“ Im Prinzip sei das eher Technical Computing oder Durchsatzrechnen in der Cloud. Echtes HPC in der Cloud sei daher „nicht wirklich bedeutsam.“

Hochleistungsrechnen und künstliche Intelligenz (KI) scheinen füreinander geschaffen zu sein: Superrechner liefern die Rechenleistung, die KI benötigt. Dass die chinesische Suchmaschine Baidu ihre KI-Anstrengungen in Frankfurt vorstellen durfte und es diesmal einen „Machine Learning Day“ gab, schürt diese Erwartung. Intel, Cray, Lenovo, Dell EMC, Atos – sie alle setzen Entwicklungsprogramme auf, die auf die Nutzbarmachung von KI abzielen. Ein Beispiel: Der spanische Superrechner „Mare Nostrum“ in Barcelona arbeitet mit Technologie von Lenovo. Eine spezielle KI-Software soll hier helfen, die Früherkennung von Augenerkrankungen zu beschleunigen und genauer zu machen.

Man sehe noch keine großen KI-Erfolgsgeschichten, wendet Michael Resch ernüchtert ein. „Das typische Anwendungsszenario ist entweder datengetrieben – dann spielt HPC nur eine geringe Rolle – oder ist HPC-getrieben, und dann sehen wir wenig Machine Learning.“ Er rechne aber künftig tatsächlich mit einem Zusammenspiel bzw. einer Fusion, nämlich überall dort, wo man eine große Datenmenge permanent durchsuchen bzw. bearbeiten muss.

Auch die deutschen Höchstleistungsrechenzentren in München, Jülich und Stuttgart sehen ihre Prioritäten derzeit nicht in der KI. Engineering in Stuttgart, Astro- und Geophysik in München sowie Grundlagenforschung in Jülich, so sieht die Arbeitsteilung aus. Die Forschung folgt der Nachfrage aus Industrie und Wissenschaft und soll einen gesellschaftlichen wie auch wirtschaftlichen Wert erbringen.

Die Zeichen stehen auf Wachstum. Überall in Europa werden zahlreiche schnelle Superrechner gebaut oder aufgerüstet. In Deutschland wurde vom Gauss Centre for Supercomputing (GCS), dem Zusammenschluss der drei deutschen Zentren, unter Leitung von Michael Resch ein Programm mit dem Namen SiVeGCS im Umfang von 460 Mio. € gestartet. Es sieht praktisch jedes Jahr bis 2023 die Inbetriebnahme eines neuen Hochleistungsrechners bzw. dessen Upgrade vor.

Ein solches Upgrade will Lenovo 2019 in München vornehmen, um 26,7 Petaflops zu liefern. Der neue, modulare Intel-Atos-Rechner Juwels in Jülich erbringt in der ersten Ausbaustufe knapp 10 Petaflops Spitzenleistung, in der zweiten Phase wird noch eine Schippe draufgelegt: Mehr als 50 Petaflops werden angepeilt. Der nächste Rechner fürs HLRS in Stuttgart, das mit seinem Cray-Rechner Hazel Hen derzeit auf Platz 27 liegt, ist für 2019 bestellt.

Zum Vergleich: Das US-amerikanische Energieministerium investiert 3 Mrd. $ in Exascale-Systeme, die jeweils Trillionen Gleitkommaoperationen pro Sekunde erledigen. Bis 2021 soll das Exascale-Niveau erreicht sein. Kein Wunder also, dass der HPC-Markt 2017 weltweit um rund 10 % gewachsen ist, wie die Markforscher von Hyperion Research herausfanden.