Künstliche Intelligenz wandert in die Fabrik

Mustererkennung in Echtzeit ist eine Domäne für künstliche Intelligenz (KI) in der Cloud. Spezialisierte Rechner sollen das künftig schnell vor Ort erledigen.

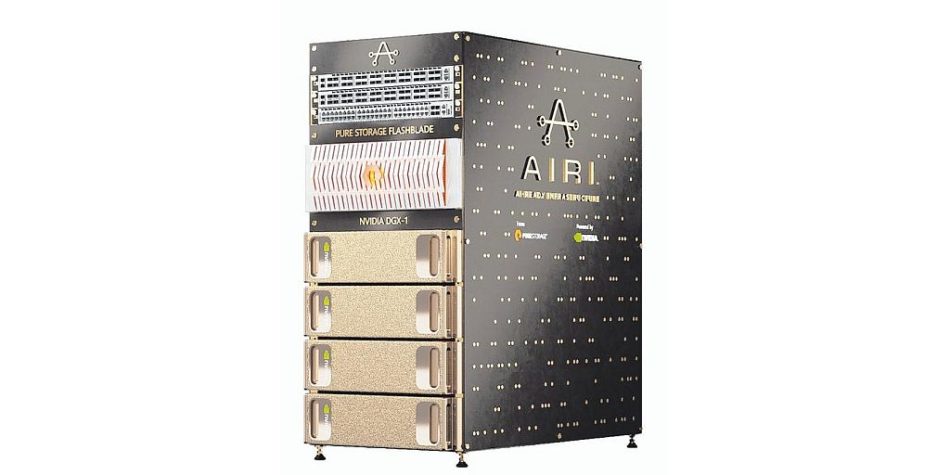

Foto: Pure Storage

Nikolai Ensslen, CEO der Synapticon GmbH, weiß: „Vollwertige kollaborative Roboter, sogenannte Cobots, müssen in der Lage sein, mit Menschen sicher und effizient zusammenzuarbeiten.“ Außerdem würden diese Systeme zunehmend mobil, müssten also auch eigenständig navigieren können.

Synapticon entwickelt Hard- und Software zur Robotersteuerung und hat eine hohe Nachfrage nach kollaborativen Robotern registriert, die im Idealfall autonom mit ihren menschlichen Kollegen zusammenarbeiten und dabei permanent lernen würden.

Zunehmend würden Anwender erkennen, dass „in der Robotik, der Automatisierungsbranche und auch im Maschinenbau immense Potenziale stecken, die erst durch den Einsatz von Systemen künstlicher Intelligenz gehoben werden können“, sagt Ensslen. Und die Marktforscher der Gartner Group geben ihm recht und sagen voraus, dass 80 % der Unternehmen bis zum Jahr 2020 künstliche Intelligenz einsetzen werden.

KI ist schon heute erfolgreich, wenn es z. B. um Mustererkennung geht, sei es von Röntgenaufnahmen, MRT-Scans, Gesichtern, Gesten oder Bewegtbildern. Für jede Erkennung ist ein Modell nötig, das das zu Erkennende annähernd beschreibt. Nur wenn das Modell umfassend trainiert wird, indem es laufend verbessert wird, wird das Objekt richtig erkannt. So lassen sich beispielsweise in einem Callcenter bald Kundenäußerungen in Echtzeit transkribieren, auswerten und zur Entscheidungsfindung des Agenten heranziehen. Auch personalisierte Medizin ist bereits in greifbare Nähe gerückt.

In der Fabrik ist der Aufwand für das Training und die erfolgreiche Anwendung eines KI-Modells sehr hoch. Für korrekte Bilderkennung ist eine große Zahl von Trainingsbildern notwendig. Diese müssen in kürzester Zeit mit Attributen versehen und im Modell geprüft werden. Auch Roboterspezialist Ensslen musste erkennen: „Die Anforderungen von Anwendungen an KI in der kollaborativen Robotik sind immens, weil große Datenmengen aus verschiedensten Quellen schnell erfasst und ausgewertet werden müssen, um dann in Sekundenbruchteilen Entscheidungen zu treffen.“

Und das gibt es nicht zum Nulltarif, weiß Ensslen: „Je leistungsfähiger die IT-Infrastruktur hinter der künstlichen Intelligenz ist, desto effizienter, flexibler und sicherer werden auch die kollaborativen Roboter.“ Diese Infrastruktur war bislang vor allem in der Cloud vorhanden, doch die Netzwerke sind noch nicht schnell genug, um die Latenzzeit zwischen Rechenzentrum und Endgerät, also dem Roboter, auf vertretbare Dauer drücken zu können. Schon eine Verzögerung von mehreren Millisekunden könnte bei der Interaktion zwischen Roboter und Mensch lebensgefährliche Situationen entstehen lassen.

Eine Möglichkeit dieses Problem zu lösen: Das Rechenzentrum muss zum Roboter kommen. Gefragt ist hohe, KI-geeignete Rechnerleistung, die nahe an den Maschinen und Robotern, die sie steuern soll, installiert werden kann. Einen Ansatz dazu hat der Grafikspezialist Nvidia bereits vorgestellt, der mit schnellen Grafikkarten und Beschleunigerchips u. a. beim Deutschen Forschungszentrum für Künstliche Intelligenz (DFKI) und beim Max-Planck-Institut für Intelligente Systeme (MPI-IS) vertreten ist: DGX-1 ist ein spezialisiertes System, das KI-Anwendungen beschleunigen soll. Kombiniert mit dem Speichersystem Flashblade des Herstellers Pure Storage und dem schnellen 100-Gbit-Ethernet des Anbieters Arista, ist daraus eine kompakte, schnell einsatzfertige Infrastruktur entwickelt worden. Das Ganze nennt sich Airi, was für AI-Ready Infrastructure steht.

Das vorkonfigurierte System, eine sogenannte Appliance, umfasst vier Nvidia-DGX-1-Supercomputer, die mit Nvidias eigenen Tesla-Grafikchips eine Rechenleistung von 4 Petaflops liefern sollen. Das sind 4 Billiarden Gleitkommaoperationen pro Sekunde. Der Datendurchsatz zum Speicher mit 15 x 17 TByte, beträgt 1,5 Mio. IOPS (Input/Output-Funktionen/s, typische Festplatten liegen unter 1000). Da KI-Modelle am schnellsten parallel verarbeitet werden, eignen sich entsprechend ausgerichtete Grafikprozessoren besonders gut für diese Aufgabe: Spezielle direkte Speicherzugriffsfunktionen sollen für maximal verteilte Lern- und Trainingsleistung sorgen.

Sowohl Nvidia als auch Pure Storage bringen ihre jeweilige KI-Software mit in das Projekt ein. Airi wird unterstützt durch Nvidias Softwarepaket „GPU Cloud Deep Learning Stack“ und das „Airi Scaling Toolkit“ von Pure Storage. Anwender brauchen nach Angaben der Hersteller kein neuronales Netzwerk wie Googles Tensorflow aus der Cloud zu integrieren, sondern haben es im Airi-Rechner integriert. Systeme wie Airi beschleunigen die breite Einführung von KI, resümiert Ritu Jyoti, Research Director für kognitives Computing, KI und Big Data Analytics beim Marktforschungsunternehmen IDC. „Sie bieten Unternehmen eine optimierte, benutzerfreundliche und robuste Lösung für jede KI-Arbeitslast.“

KI habe sich von einer hypothetischen Zukunftstechnologie zu einer realen, geschäftskritischen Komponente entwickelt, meint Jyoti. „Es gibt eine zunehmende Nutzung von KI in allen Branchen“, wodurch neue Geschäftsmodelle, genauer definierte Wertversprechen, effizientere Prozesse und stärker personalisierte Verbrauchererlebnisse möglich würden. Synapticon-Chef Ensslen sieht ähnliche Trends für andere Bereiche der Automatisierung und des Maschinenbaus: „Die schnelle Verarbeitung von Daten sowie die Integration maschinellen Lernens werden zu entscheidenden Merkmalen moderner Roboter.“